당신이 원하는 방식 그대로, AI. 간편하고, 강력하며, 안전합니다.

Msty Studio는 여러분을 위한 올인원 AI 스튜디오입니다. 로컬 및 온라인 모델을 자유롭게 조합하고,

강력한 어시스턴트를 구축하며, 워크플로우를 자동화해 보세요. 이제 AI가 온전히 당신을 위해 일하도록 만들 수 있습니다.

주요 특징과 사용법은 다음과 같습니다.

1. 로컬 및 온라인 모델의 자유로운 활용 (하이브리드 AI)

로컬 모델 (오프라인)사용시 인터넷 연결 없이 내 PC의 성능(GPU/CPU)을 활용하여 Llama 3, DeepSeek, Gemma 같은 최신 오픈소스 모델을 무료로 다운로드하고 돌릴 수 있습니다. 데이터가 외부로 나가지 않아 보안상 매우 안전합니다.

온라인 모델이 필요하다면 OpenAI(GPT-4), Anthropic(Claude) 등의 API 키를 연동하여, 하나의 앱 안에서 최고 성능의 상용 모델들도 함께 사용할 수 있습니다.

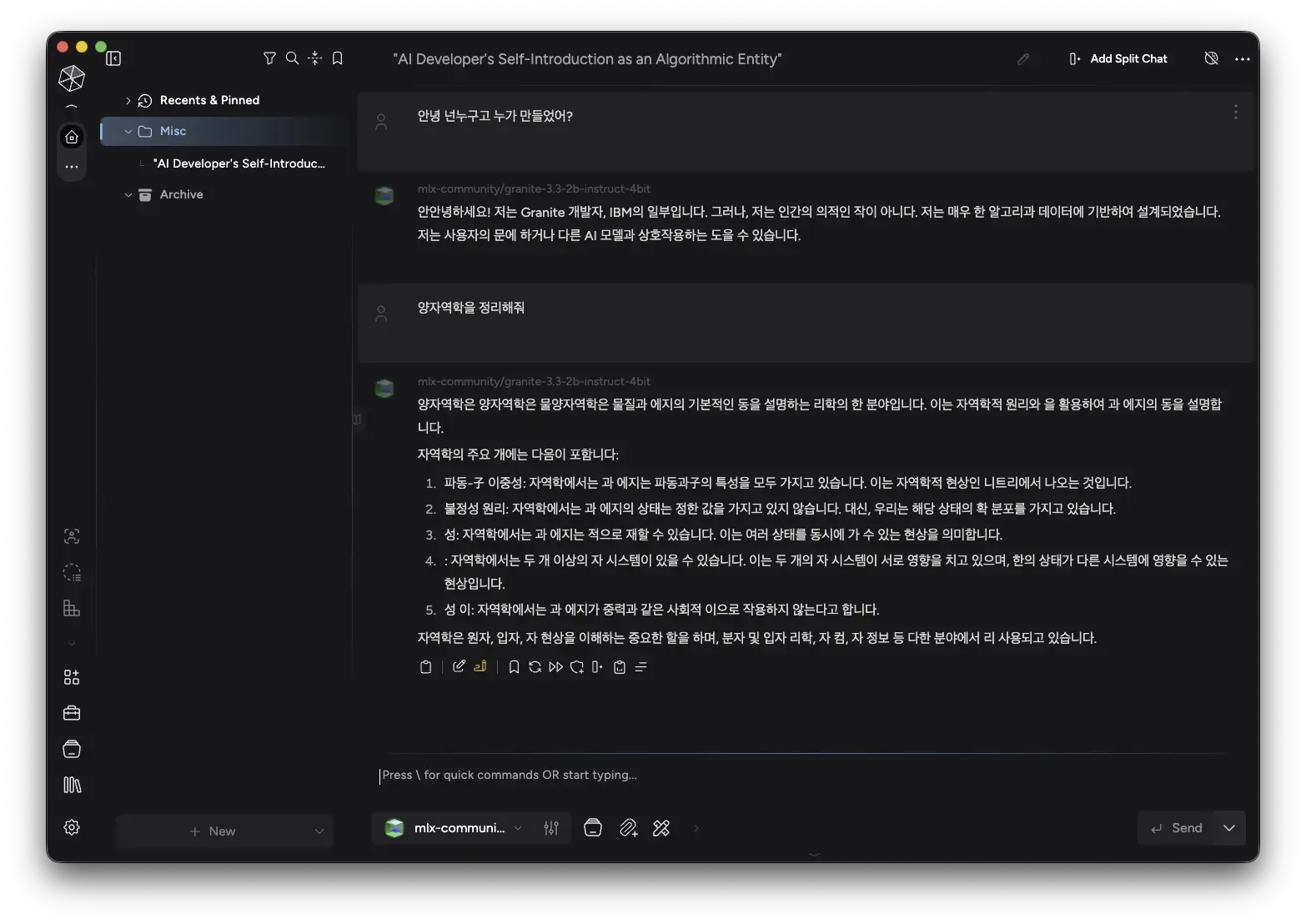

2. 강력하고 편리한 기능들분할 채팅 (Split Chat)

화면을 나누어 두 개 이상의 AI 모델과 동시에 대화할 수 있습니다.

예를 들어, 똑같은 질문을 'Llama 3'와 'GPT-4'에게 동시에 던져 답변 품질을 바로 비교해 볼 수 있어 매우 유용합니다.

나만의 지식 베이스 (Knowledge Stacks): PDF 문서나 텍스트 파일 등을 Msty에 업로드하면, AI가 그 문서 내용을 바탕으로 답변해 줍니다(RAG 기술). 회사 내부 문서나 논문 등을 분석할 때 탁월합니다.

실시간 웹 검색: 로컬 모델이라도 설정을 통해 실시간 인터넷 검색 결과를 반영한 답변을 하도록 만들 수 있습니다.

3. 압도적인 편의성 원클릭 설치

복잡한 명령어(터미널, 도커 등)를 전혀 몰라도 됩니다.

일반적인 윈도우/맥 프로그램처럼 설치 파일 하나로 바로 실행됩니다.

통합 관리: 여러 AI 모델을 앱 하나에서 다운로드, 업데이트, 삭제하며 관리할 수 있어 쾌적합니다.

2.1.0 달라진점 - https://msty.ai/changelog

-

Llama.cpp 네이티브 지원

이제 Llama.cpp를 로컬 추론 엔진으로 공식 지원합니다. 이를 통해 로컬 모델을 구동할 때 한층 더 유연하고 강력한 옵션들을 활용하실 수 있습니다. -

섀도우 페르소나 (Aurum 전용)

섀도우 페르소나는 메인 대화를 관찰하며, 대화 흐름 밖에서 독자적인 피드백을 제공합니다. 여러 분할 채팅(Split Chats)의 결과를 분석 및 종합하여 최적의 답변을 도출하거나, 지식 스택(Knowledge Stacks), 툴박스, 실시간 데이터 등을 활용해 다양한 작업을 수행하는 등 최고의 대화 파트너가 되어 드립니다. -

워크스페이스 잠금 및 암호화 (실험적 기능)

비밀번호(Passphrase)를 설정해 워크스페이스를 잠글 수 있는 기능이 추가되었습니다. 이 실험적 기능을 통해 개인정보 보호 및 보안을 한층 더 강화할 수 있습니다. -

대화 자동 보관 (Auto-archive)

오래된 대화를 자동으로 보관 처리하여 목록을 깔끔하게 유지합니다. 보관된 대화는 '아카이브(Archive)' 폴더에서 언제든 다시 확인하실 수 있습니다. -

분실물 찾기 (Lost & Found)

연결이 끊긴(Orphaned) 워크스페이스를 검색하여 Msty Studio로 다시 불러올(Re-import) 수 있는 기능을 제공합니다. -

프로젝트 및 대화 정렬 설정

프로젝트와 대화의 정렬 기준, 순서, 표시 방식을 세부적으로 설정하여 프로젝트 폴더 구조를 사용자 편의에 맞게 최적화할 수 있습니다. -

모델 목록 정렬

모델 선택 목록 또한 위와 유사한 정렬 옵션을 제공하여, 원하는 순서대로 모델을 나열하고 관리할 수 있습니다.

OS: macOS 11+

SHA256: B4D58622DFF66475226A4FE233B9BAFC09C089CB2453BB6136B3E5F4AB965FCA

다운로드 : MstyStudio_arm64.dmg

--------------------------------------------------------------------------------------광고(Advertising)--------------------------------------------------------------------------------------------------------